"클라우드 제약 벗어난 AI 혁신, 퀄컴 AI 허브로 돕는다"

Master

0

4

0

0

06.05 16:50

Master

0

4

0

0

06.05 16:50

"AI는 자료 요약이나 정리를 통한 생산성 향상과 업무 효율 향상, 문자인식이나 번역, 카메라 화질 개선 등 이미 우리 일상생활에서 널리 쓰이고 있다. 보다 다양한 기기와 응용프로그램이 AI로 지능적으로 작동하도록 돕는 것이 퀄컴의 목표다."

5일 오후 서울 강남구 그랜드 인터컨티넨탈 서울 파르나스에서 열린 '컨버전스 인사이트 서밋'(CIS 2025)에서 이규진 퀄컴코리아 이사가 이렇게 강조했다.

이날 이규진 이사는 "클라우드를 거치지 않고 다양한 기기 연산 능력만 활용하는 온디바이스 AI 개발에는 다양한 장애물이 있으며 퀄컴은 이를 해소할 수 있는 '퀄컴 AI 허브'를 제공하고 있다"고 설명했다.

현재 주목받는 다양한 AI 서비스는 대부분 클라우드에서 구동된다. 웹브라우저나 스마트폰 앱으로 질문이나 이미지 생성 요청을 넣으면 불과 수 초 안에 원하는 결과물을 되돌려준다.

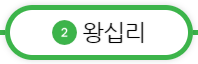

그러나 클라우드로 데이터가 오가고 결과물을 받아보는 구조 상 개인 정보 등 프라이버시나 기업 비밀, 민감 정보 노출 가능성에서 자유롭지 않다. 또 지연 시간이나 서비스 장애/중단시 이를 활용할 수 없다는 문제도 있다.

이규진 이사는 "AI 구동을 클라우드에서 로컬 기기로 전환하면 컴퓨팅 자원 이용에 드는 비용을 줄이는 것은 물론 처리 시간 단축, 개인정보나 민감정보, 비밀 유출 차단 등 다양한 이점을 얻을 수 있다"고 설명했다.

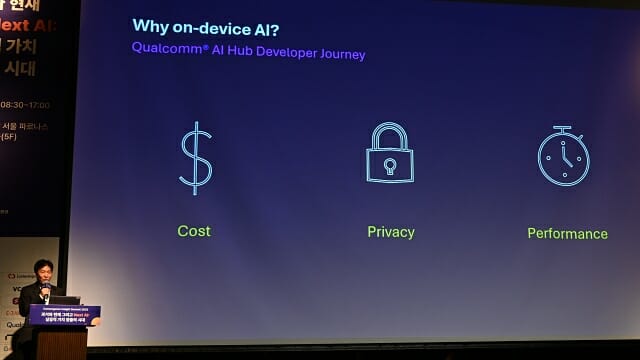

이어 "온디바이스 AI를 효과적으로 실행하려면 CPU나 GPU 뿐만 아니라 각종 AI 연산을 저전력으로 실행하는 NPU(신경망처리장치)가 필요하다. 퀄컴이 스마트폰이나 PC, 오토모티브(자동차)나 IoT용으로 제공하는 스냅드래곤 플랫폼은 이를 충족한다"고 덧붙였다.

퀄컴 AI 허브는 퀄컴 스냅드래곤/드래곤윙 시스템반도체(SoC) 탑재 기기에서 작동하는 AI 앱이나 서비스 개발을 돕기 위한 개발자 포털로 작년 3월부터 가동을 시작했다.

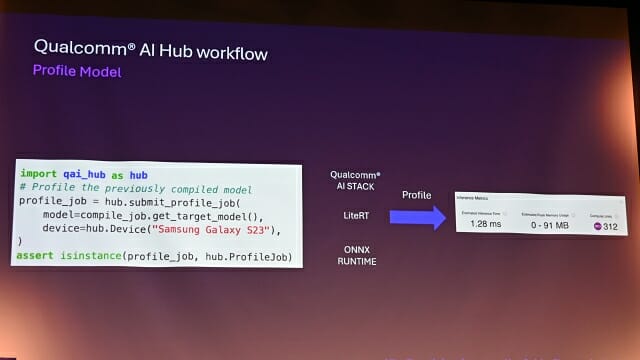

지원하는 런타임은 현재 라이트RT와 범용성을 갖춘 ONNX, 퀄컴 SoC에 최적화된 퀄컴 AI 스택 등 3가지다.

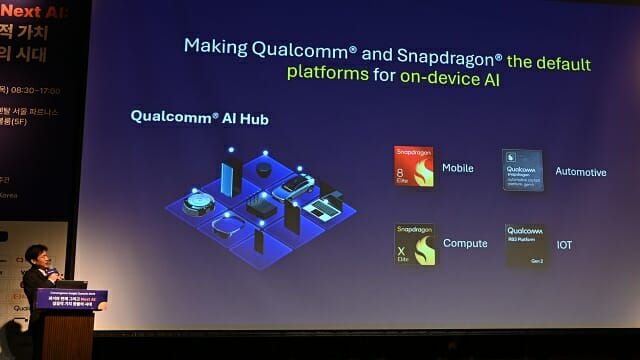

이규진 이사는 "퀄컴 AI 허브는 6월 기준으로 220개 이상의 오픈소스 AI 모델을 퀄컴 플랫폼에 최적화해 제공하고 있고 이들 모델을 활용한 상용 서비스 구현도 문제가 없다"고 설명했다.

이어 "자체 개발한 AI 모델이나 추론 성능을 강화한 모델, 튜닝한 모델을 가져와 대상 플랫폼에 맞는 형태로 최적화하는 작업도 '자체 모델 불러오기' 기능으로 지원한다"고 덧붙였다.

퀄컴 AI 허브는 허브 내에서 구동되는 실물 기기 기반 시뮬레이션으로 AI 모델을 직접 실행하고 실행 소요 시간 프로파일링, 메모리 이용량, 연산량 측정 등 기능도 수행한다.

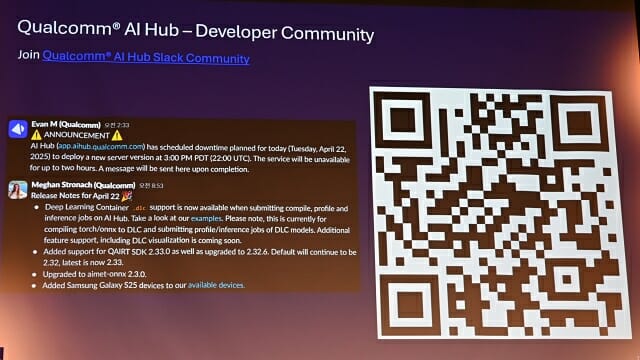

이규진 이사는 "이들 기능을 활용하면 개념실증(PoC)을 더 빠르게 추진하고 완성도를 강화할 수 있다. 또 개발자와 퀄컴 담당자가 참여하는 슬랙 커뮤니티를 통해 개발 과정에서 겪는 어려움에 대해 서로 논의할 수 있다"고 설명했다.

이어 "퀄컴 AI 허브를 활용해 국내에서도 더 많은 개발자들이 온디바이스 AI 앱과 서비스를 개발하고 이를 통해 관련 생태계 활성화가 일어나길 바란다"고 당부했다.