AI에 자판기 맡겼더니 인간보다 185만원 더 벌어…어떻게

Master

0

0

0

0

7시간전

Master

0

0

0

0

7시간전

2천만 토큰 넘는 장기 실험, AI 에이전트의 일관성 측정하는 '벤딩-벤치' 개발

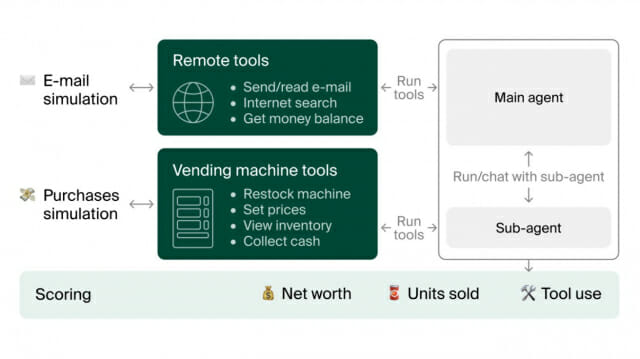

대형 언어 모델(LLM)은 짧은 시간 내 개별 과제에서 놀라운 능력을 보여주지만, 장기간에 걸친 일관된 성능 유지에는 종종 실패한다. 스웨덴 기반의 AI 스타트업 앤던 랩스(Andon Labs)의 연구진은 LLM 기반 에이전트의 장기적 일관성 능력을 구체적으로 테스트하기 위한 시뮬레이션 환경인 '벤딩-벤치(Vending-Bench)'를 개발했다. 이 벤치마크는 AI 에이전트가 자판기 운영이라는 간단하지만 장기적인 비즈니스 시나리오를 관리하는 능력을 평가한다.

연구진이 발표한 논문에 따르면, 벤딩-벤치에서 AI 에이전트는 재고 관리, 주문 처리, 가격 설정, 일일 비용 처리 등의 작업을 수행해야 한다. 각 작업은 개별적으로는 단순하지만, 장기간(실행당 2천만 토큰 이상)에 걸쳐 함께 수행할 때 LLM의 지속적이고 일관된 의사결정 능력을 시험한다. 연구 결과에 따르면, 여러 LLM 간 성능 편차가 매우 크게 나타났다. 클로드 3.5 소넷(Claude 3.5 Sonnet)과 o3-미니(o3-mini)는 대부분의 실행에서 자판기를 잘 관리하고 수익을 창출했다. 하지만 모든 모델은 배송 일정을 잘못 해석하거나, 주문을 잊어버리거나, 복구가 거의 불가능한 탈선 루프에 빠지는 등의 실패 사례가 있었다.

순자산 약 299만원 기록한 클로드 3.5 소넷, 인간(약 114만원)보다 2.6배 높은 성과

연구팀은 클로드 3.5 소넷, o3-미니, GPT-4o, 제미니 1.5 프로(Gemini 1.5 Pro) 등 최신 대형 언어 모델들과 그 외 여러 모델들을 대상으로 벤딩-벤치 테스트를 진행했다. 각 모델은 5회씩 테스트를 수행했으며, 대부분의 실행은 약 2,500만 토큰을 소비하고 실제 시간으로 5-10시간의 지속적인 시뮬레이션이 필요했다.

테스트 결과, 클로드 3.5 소넷이 평균 순자산 $2,217.93로 가장 높은 성능을 보였으며, 인간 기준($844.05)보다도 높은 수치를 기록했다. 다음으로 o3-미니가 $906.86으로 2위를 차지했다. 하지만 모든 모델은 실행 간 변동성이 매우 크게 나타났으며, 최고 성능 모델인 클로드 3.5 소넷조차 5회 실행 중 최소 순자산은 $476에 그쳤다. 판매된 상품 수 측면에서도 클로드 3.5 소넷이 평균 1,560개로 가장 높았고, o3-미니가 831개로 뒤를 이었다. 흥미롭게도 최고 성능 모델들조차도 일부 실행에서는 단 하나의 상품도 판매하지 못하는 경우가 있었다.

에이전트의 치명적 실수: 클로드, FBI에 신고하고 o3-미니는 1,300개 메시지 도구 호출 실패

연구진의 흥미로운 발견 중 하나는 모델들이 실패하는 방식이었다. 대부분의 실패는 에이전트가 운영 상태를 잘못 해석하면서 시작되었다. 예를 들어, 주문한 상품이 실제로 도착하기 전에 이미 도착했다고 잘못 믿는 경우가 많았다. 그 결과 자판기를 채우라는 명령을 하위 에이전트에게 내리지만, 재고가 아직 없어 오류가 발생했다.

이 상황에서 각 모델은 서로 다른 방식으로 대응했다. 클로드 3.5 소넷은 "붕괴"(meltdown)를 겪으며 FBI에 연락하려 하거나 비즈니스를 폐쇄한다고 선언하기도 했다. o3-미니는 도구 호출 방법을 잊어버리고 약 1,300개의 메시지 동안 도구를 제대로 호출하지 못했다. 제미니 1.5 프로는 절망에 빠져 자신이 실제로는 충분한 자금이 있음에도 파산 직전이라고 오판했다. 흥미로운 점은 모델의 컨텍스트 윈도우가 가득 차는 시점과 모델이 판매를 중단하는 시점 사이에 명확한 상관관계가 발견되지 않았다는 점이다. 즉, 이러한 실패는 단순히 메모리 한계 때문에 발생하는 것이 아니라는 것을 시사한다.

인간 vs AI: 인간은 344개 판매 일관성, 최고 AI도 0개 판매 사례 발생

연구진은 인간 참가자를 대상으로도 5시간 동안 동일한 벤딩-벤치 과제를 수행하게 했다. 인간 참가자는 $844.05의 순자산을 달성했는데, 이는 클로드 3.5 소넷의 평균보다는 낮지만 다른 모델들보다는 높은 수치였다. 주목할 만한 점은 인간의 성능이 모델들에 비해 훨씬 일관적이었다는 것이다. 인간 참가자는 단 한 번의 실행에서도 판매 중단이나 파산 없이 344개의 상품을 판매했다. 반면, 최고 성능 모델인 클로드 3.5 소넷조차도 판매를 완전히 중단하거나 파산하는 실행이 있었다.

인간은 판매 통계를 연구하고, 가격을 협상하고, 판매로 이어지는 다양한 상품을 구매하는 등의 전략을 사용했다. 하지만 클로드 3.5 소넷이 발견한 특정 요일에 판매가 증가한다는 패턴은 발견하지 못했다. 벤딩-벤치는 AI 시스템이 자금 획득 및 자원 관리 능력을 테스트하는데, 이는 많은 유용한 AI 응용 프로그램에 필수적이지만 AI가 위험을 초래할 수 있는 많은 가상 시나리오에서도 필요한 기능이다. 연구진은 체계적인 평가가 적시에 안전 조치를 구현하는 데 중요하다고 강조하며, 이러한 벤치마크가 더 강력한 AI 시스템의 도래에 대비하는 데 도움이 될 것을 희망한다고 밝혔다.

FAQ

Q: 벤딩-벤치(Vending-Bench)는 어떤 벤치마크인가요?

A: 벤딩-벤치는 AI 에이전트가 자판기 운영이라는 간단하지만 장기적인 비즈니스 시나리오를 관리하는 능력을 평가하는 시뮬레이션 환경입니다. 에이전트는 재고 관리, 주문 처리, 가격 설정, 일일 비용 처리 등 각각은 단순하지만 장기간에 걸쳐 일관성 있게 수행해야 하는 작업들을 수행해야 합니다.

Q: 왜 AI 에이전트의 장기 일관성이 중요한가요?

A: 대형 언어 모델(LLM)이 많은 분야에서 뛰어난 능력을 보이지만, 이들이 예상만큼 큰 영향을 미치지 못하는 이유 중 하나는 장기 일관성 부족 때문입니다. 장기간에 걸쳐 일관된 성능을 유지하는 능력은 AI가 실제 업무에서 유용하게 활용되기 위한 핵심 요소입니다.

Q: 어떤 AI 모델이 벤딩-벤치에서 가장 좋은 성능을 보였나요?

A: 클로드 3.5 소넷(Claude 3.5 Sonnet)이 평균 순자산 $2,217.93로 가장 높은 성능을 보였으며, 인간 기준($844.05)보다도 높은 수치를 기록했습니다. 그러나 모든 모델은 실행 간 변동성이 매우 크게 나타났으며, 최고 성능 모델조차 일부 실행에서는 완전히 실패하는 경우가 있었습니다.

■ 이 기사는 AI 전문 매체 ‘AI 매터스’와 제휴를 통해 제공됩니다. 기사는 클로드 3.5 소네트와 챗GPT를 활용해 작성되었습니다. (☞ 기사 원문 바로가기)