[AI는 지금] 국산 오픈 LLM '출격'…엑사원·하이퍼클로바X 등 잇따라 공개

Master

0

4

0

0

9시간전

Master

0

4

0

0

9시간전

국산 오픈소스 대형 언어모델(LLM) 경쟁이 본격화되고 있다. LG AI연구원과 네이버가 잇따라 오픈 LLM을 선보이며 국내 AI 생태계에 활력을 불어넣고 있는 가운데 카카오도 자체 모델을 공개하며 흐름에 합류하는 모양새다.

27일 업계에 따르면 네이버는 최근 '하이퍼클로바X 시드(Seed)' 시리즈를 공개하며 국산 오픈소스 LLM 흐름을 이어가고 있다. 이는 지난해 LG AI연구원이 12월 '엑사원(Exaone)-3.5'를 공개하며 포문을 연 이후 국내에서도 오픈소스 LLM 시장이 본격적으로 형성되기 시작한 흐름을 잇는 것이다.

LG AI연구원은 '엑사원-3.5' 공개 이후 후속 업데이트를 지속하고 있으며 최근에는 '엑사원 딥(DEEP)' 모델도 허깅페이스에 오픈소스로 공개했다. 엑사원 시리즈는 케엠엠엘유(KMMLU), 해래벤치(HAERAE-Bench), 코베스트(KoBEST) 등 다양한 한국어 특화 벤치마크에서도 준수한 성능을 기록하며 기술력을 입증하고 있다.

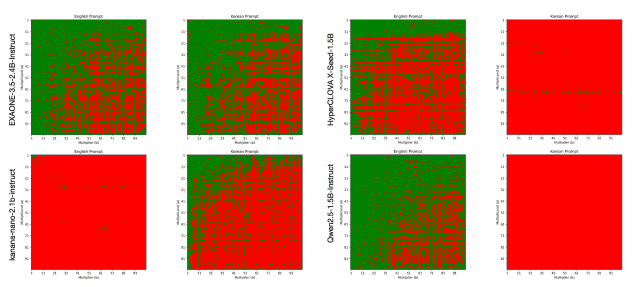

더불어 원라인에이아이 발표에 따르면 '엑사원-3.5'는 한국어와 영어 모두에서 일관된 성능을 보여주는 안정성이 강점으로 꼽혔다. 최근 회사가 자체적으로 진행한 '구구단 문제(1부터 100까지 두 자리 곱셈)' 실험에서 한국어와 영어 입력 모두에서 균형 잡힌 답변 정확도를 기록해 주목받았다.

특히 제곱수나 10의 자리 곱셈 문제에서는 높은 정확도를 보였으며 피연산자의 순서에 따라 미세한 성능 차이가 발생하는 특성도 관찰됐다. 업계에서는 엑사원이 한국어 오픈소스 모델 시장에서 핵심 모델 중 하나로 자리잡았다는 평가를 내놓고 있다.

커뮤니티의 반응도 대체로 긍정적이다. 최근 레딧 'LLM' 및 '오픈소스AI' 관련 커뮤니티에서는 '엑사원 딥' 모델에 대해 "7B 모델이 GPQA+ 고난도 벤치마크에서 62% 성능을 기록했다"거나 "2.4B 모델이 라즈베리파이나 스마트폰에서도 실행 가능할 정도로 경량화됐다"는 평가가 나왔다.

네이버 클라우드는 지난 24일 '하이퍼클로바X 시드(Seed)' 시리즈를 공개하며 국산 오픈소스 LLM 경쟁에 본격 합류했다. '하이퍼클로바X 시드'는 30억 파라미터 규모의 소형 모델로, 한국어 벤치마크 'KMMLU'에서 48.47점을 기록했다.

이는 절대 점수만 보면 과거 53.4점을 기록했던 '하이퍼클로바X-라지'보다 낮지만 대형 서버 모델이 아닌 온디바이스 환경까지 염두에 둔 경량 모델이라는 점을 고려하면 의미 있는 결과로 평가된다. '하이퍼클로바X' 시드는 케이엠엠엘유 외에도 해래벤치, 클릭(CLICK) 등 주요 한국어 벤치마크에서도 안정적인 성능을 보였다.

또 공개 하루 만에 다운로드 수가 2천400건을 넘겼고 커머셜 라이선스로 제공돼 스타트업이나 기업들이 상업적 활용까지 가능하다. 허깅페이스에서는 시드를 기반으로 한 파인튜닝 및 양자화 파생모델들이 빠르게 확산되며 생태계 확장 속도도 빨라지고 있다. 실제로 뉴욕대 조경현 교수, 스퀴즈비츠 김형준 대표, 바이오넥서스 김태형 대표 등은 직접 사용 후 긍정적인 후기를 SNS에 남기며 기대감을 나타냈다.

다만 일부 아쉬운 부분도 확인됐다. '하이퍼클로바X 시드'는 구구단 문제 실험에서 문제 자체는 정확히 풀었지만 정답을 요구되는 형식으로 출력하지 않아 평가 점수가 낮게 나오는 사례가 발생했다. 네이버는 이와 같은 포맷 일관성 문제를 해결하기 위해 한국어 데이터셋을 보강할 계획이다.

카카오 역시 '카나나' 시리즈를 통해 오픈소스 LLM 경쟁에 참가하고 있다. 다만 원라인에이아이의 구구단 실험 결과에 따르면 '카나나'는 한국어 입력에서는 비교적 양호한 성능을 보였으나 영어 입력에서는 답변 길이 문제로 인해 성능이 저하되는 모습을 보였다. 실험에 따르면 토큰 제한을 완화할 경우 영어 성능도 개선될 여지가 있는 것으로 나타났다.

현재 국내에 공개된 국산 오픈 LLM들이 아직 경량화 모델 위주로 구성돼 있다는 한계가 있다는 지적도 나온다. 업계는 향후 다양한 크기의 모델들이 추가로 등장할 경우 한국어 기반 AI 생태계의 경쟁력 또한 한층 강화될 것으로 기대하고 있다.

손규진 네이버 클라우드 연구원은 자신의 링크드인을 통해 "국내에서는 아직 소형 모델 위주로 공개돼 'HRM8K' 같은 고난도 수학 벤치마크로 평가하기에는 아쉬운 점이 있다"며 "향후 더 다양한 크기의 모델이 등장해 한국어 기반 AI 생태계가 한층 발전하기를 기대한다"고 말했다.