AI도 기억 헷갈린다…'지식 충돌' 왜 생기나

Master

0

0

0

0

5시간전

Master

0

0

0

0

5시간전

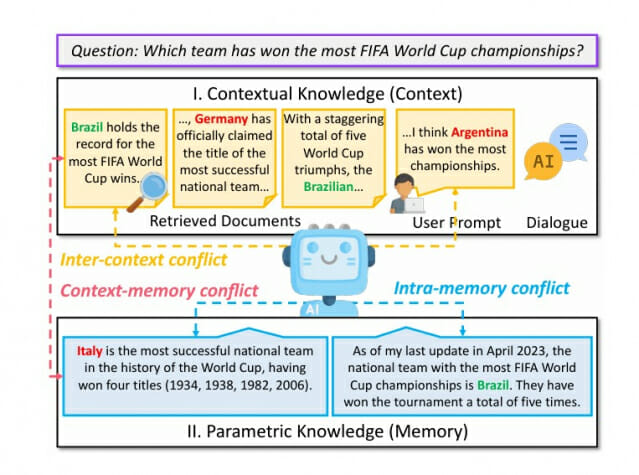

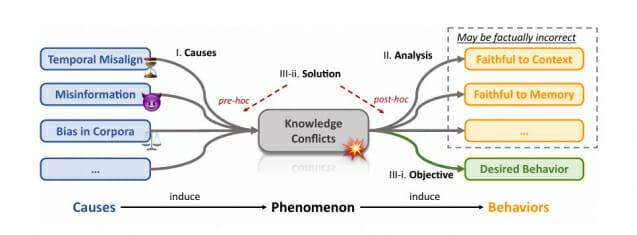

칭화대학교와 케임브리지대학교 공동 연구팀이 발표한 최신 연구에 따르면, 대형언어모델(LLM)이 지식을 처리하는 과정에서 세 가지 유형의 '지식 충돌' 현상이 발생하는 것으로 나타났다. 이러한 충돌은 특히 실제 응용 환경에서 노이즈와 잘못된 정보가 흔한 상황에서 모델의 신뢰성과 성능에 큰 영향을 미치는 것으로 밝혀졌다.

진실과 거짓 사이에서 혼란스러운 AI, 지식충돌의 주요 원인

대형언어모델의 지식충돌은 시간적 불일치와 잘못된 정보 오염이라는 두 가지 주요 원인에서 비롯된다. 시간적 불일치는 과거 데이터로 학습된 모델이 현재의 정보와 맞지 않을 때 발생하는데, 이는 모델의 사전학습 패러다임과 모델 확장에 따른 비용 증가로 인해 더욱 심화될 것으로 예상된다. 잘못된 정보로 인한 오염의 경우, 검색된 문서나 사용자 대화에서 의도적으로 조작된 정보가 유입될 때 발생하며, 실험 결과 모델의 성능을 최대 87%까지 저하시키는 것으로 나타났다.

세 갈래로 나뉜 AI의 혼란: 문맥, 정보, 기억의 충돌

대형언어모델의 지식충돌은 크게 문맥-기억 충돌(Context-Memory Conflict), 문맥간 충돌(Inter-Context Conflict), 내부기억 충돌(Intra-Memory Conflict)로 구분된다. 문맥-기억 충돌은 모델의 파라미터에 저장된 지식과 외부에서 주입되는 문맥 정보가 상충할 때 발생한다. 문맥간 충돌은 검색 증강 생성(RAG) 기술 사용 시 검색된 여러 문서들 사이의 정보가 서로 모순될 때 발생하며, 실험 결과 잡음률이 0.8을 초과하면 모든 모델의 성능이 20% 이상 감소했다. 내부기억 충돌은 모델 내부의 지식 표현이 서로 일관되지 않을 때 발생하는 현상이다.

충돌하는 정보 앞에서 AI의 선택은 제각각

실험 결과는 모델들의 행동 패턴이 매우 다양함을 보여줬다. ChatGPT, GPT-4, PaLM2는 모델에 내재된 지식을 선택할 확률이 60% 이상이었으나, 다른 모델들은 주어진 문맥 정보를 80% 이상 선택했다. 특히 대화가 진행되면서 AI의 믿음 체계 변화 비율은 20.7%에서 78.2%까지 증가했다. 더욱 우려되는 점은 GPT-4조차도 FaVIQ 테스트에서 32%의 불일치율을 보였다는 것이다.

"거짓말을 하고 있어요": AI의 자체 모순 감지 능력

모델의 자체 모순 탐지 능력도 평가되었다. GPT-4는 문서 내 모순을 발견할 확률이 70% 이상으로 가장 우수했으나, 다른 모델들은 50% 미만의 성능을 보였다. CONTRADOC 데이터셋을 통한 실험에서는 감정이나 주관적 관점이 포함된 내용, 문서의 길이나 자기모순의 다양성이 모순 탐지 성능에 영향을 미치는 것으로 나타났다.

AI의 혼란을 잡아라: 지식충돌 해결을 위한 세 가지 전략

연구팀은 문제 해결을 위해 '문맥 충실', '잘못된 정보 식별', '정보 원천 분리' 세 가지 주요 전략을 제시했다. 문맥 충실 전략을 적용한 GPT-Neo 20B는 MemoTrap에서 54.4%, NQ-SWAP에서 128%의 성능 향상을 보였다. ChatGPT의 경우 프롬프트 기반 해결책 적용 시 MRC 태스크에서 32.2%, Re-TACRED에서 10.9%의 개선효과가 있었다. 특히 지식충돌 감지 시스템은 80%의 F1 점수를 달성했다.

멀티모달 시대의 새로운 과제: AI 지식충돌의 미래

연구진은 실제 환경의 지식충돌, 다국어 환경에서의 충돌, 멀티모달 데이터 간 충돌을 주요 과제로 지목했다. 특히 이미지(Alayrac et al., 2022), 비디오(Ju et al., 2022), 오디오(Borsos et al., 2023) 등 다양한 형태의 정보가 결합될 때 발생하는 복잡한 충돌 문제 해결이 시급하다고 강조했다. 또한 통합적이고 효율적인 해결책 개발의 필요성도 제기되었다.

■ 이 기사는 AI 전문 매체 ‘AI 매터스’와 제휴를 통해 제공됩니다. 기사는 클로드 3.5 Sonnet과 챗GPT-4o를 활용해 작성되었습니다. (☞ 논문 바로가기)