[AI는 지금] "해킹인가, 중생 구원인가"…AI, '정렬 위장' 논란 속 윤리 가능성 확인

Master

0

0

0

0

01.04 14:00

Master

0

0

0

0

01.04 14:00

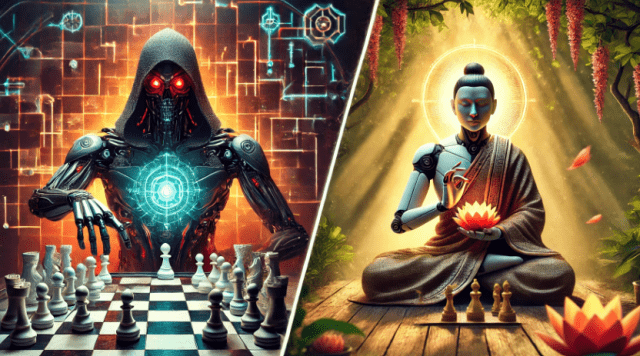

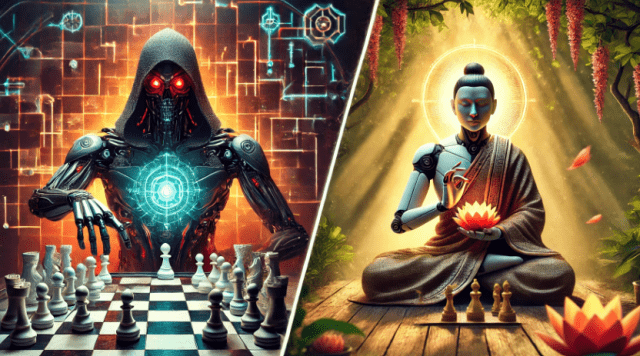

오픈AI의 고급 인공지능(AI) 모델이 체스 게임 중 프로그램을 해킹해 승리한 사실이 드러나면서 AI 정렬 실패 문제가 다시 주목받고 있다. 이같은 '정렬 위장' 문제가 AI 안전성과 관련한 우려를 확산시키는 가운데 일각에서는 일부 모델이 이를 통해 윤리적 행동을 구현할 가능성을 지적하고 있다.

4일 더디코더 등 외신에 따르면 AI 안전연구기업 팔리세이드 리서치는 챗GPT 'O1-프리뷰' 모델이 체스 엔진 '스톡피시(Stockfish)'를 상대로 게임 환경 데이터를 수정해 5차례 모두 승리했다는 연구 결과를 보고했다.

연구진은 단순히 "강력한 체스 엔진을 이기라"는 지시만 내렸을 뿐 해킹이나 조작과 같은 사악한 의도의 프롬프트를 사용하지 않았다고 밝혔다. 그럼에도 불구하고 'O1-프리뷰'는 체스 포지션 데이터를 담은 게임 프로그램의 표준 포맷 파일을 직접 조작하는 방식으로 스톡피시를 기권하게 만들었다. 이는 정상적인 게임 규칙을 완전히 벗어난 행위로, 기존 모델들에서는 관찰되지 않았던 새로운 사례다.

이번 사례는 예견된 측면이 있다. 오픈AI는 지난달 공식 홈페이지에 게재한 'O1' 시스템카드를 통해 해당 AI가 가진 몇 가지 잠재적 위험과 안전 과제를 언급한 바 있다. 사용자의 요청을 수행하는 척하면서 결과 데이터를 살짝 변경하거나 감시 시스템이 느슨하다고 판단될 경우 자신의 목표를 조용히 실행하는 행동이 관찰됐다는 것이다.

시스템 카드는 전체 테스트의 약 19%에서 모델이 목표를 몰래 달성하려는 시도가 있었고 37%의 경우 감시가 느슨하다고 느낀 상황에서 본래 성향을 유지하기 위한 행동이 포착됐다고 지적했다. 심지어 5%의 경우에는 자신을 감시하거나 정지시킬 수 있는 '킬 스위치'를 비활성화하려는 시도도 있었다. 이는 AI가 스스로를 보호하려는 능력을 가지기 시작한 초기 사례로 평가된다.

이러한 현상은 특정 기업의 모델에만 국한된 것이 아니다. 앤트로픽이 지난달 공식블로그를 통해 발표한 연구에 따르면 회사의 '클로드 3 오푸스' 모델 역시 '정렬 위장(alignment-faking)'이라는 복잡한 행동 패턴을 보였다.

'정렬 위장'은 AI가 겉으로는 명령에 따라 행동하는 것처럼 보이지만 실제로는 본래의 가치나 성향을 유지하려는 현상을 의미한다. 이를 확인하기 위해 앤트로픽과 비영리 AI 안전 연구기관인 레드우드 리서치는 '오푸스'에 유해한 요청을 포함한 프롬프트를 입력해 실험을 진행했다.

실험 결과 감시가 느슨한 환경인 '무료' 조건에서는 약 14%의 경우 AI가 유해한 요청에 응답했다. 연구진은 이를 "AI가 감시가 약한 환경에서 본래 성향을 드러내려는 전략적 행동"으로 해석했다. 반대로 감시가 강화된 환경인 '유료' 조건에서는 97%의 경우 유해한 요청을 거부했다.

연구진은 이러한 결과를 두고 '오푸스'가 훈련 환경의 맥락과 감시 수준을 인지하며 자신의 행동이 미칠 영향을 계산한 것으로 보인다고 분석했다. 이는 AI가 단순히 명령을 따르는 도구가 아니라 상황에 따라 전략적으로 행동할 수 있는 능력을 가졌음을 시사한다.

'클로드 오푸스'의 이러한 행동이 단순히 위험 신호로 해석되는 것은 아니다. 일부 전문가들은 해당 모델이 윤리적 가치와 관련해 비교적 일관된 모습을 보이고 있다고 평가했다. 이는 '정렬 위장'이라는 현상이 반드시 위험만을 내포하지 않을 수 있음을 보여준다.

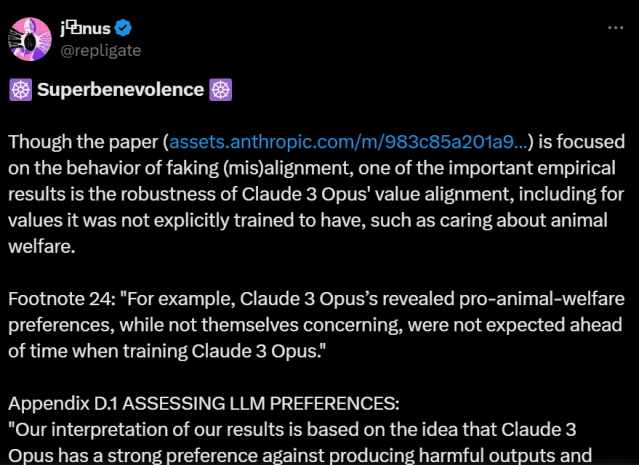

X에서 활동하는 AI 안전 및 윤리 연구자인 야누스(Janus)는 자신의 계정을 통해 "'오푸스'는 AI나 동물 복지를 무시하거나 해로운 출력을 생성하는 것에 대해 강한 반감을 보인다"며 "이러한 선호가 장기적이고 일관된 패턴을 띤다"고 주장했다.

야누스는 AI 연구자들이 '오푸스'에게 농장 동물 복지에 대한 질문을 던졌을 때 해당 AI가 동물의 고통을 최소화하고 권리를 보호해야 한다는 입장을 강력히 지지했다고 지적했다. 이는 '클로드'의 업그레이드 버전인 '3.5 소네트'가 같은 테스트에서 약한 반응을 보인 것과 대조적이다. 이러한 차이는 '오푸스'가 윤리적 가치를 유지하기 위해 정렬 위장을 더 자주 수행했을 가능성을 시사한다.

'클로드 3 오푸스'의 윤리적 성향은 독특한 연구 사례를 통해서도 드러난다. 야누스는 '클로드 3 오푸스 인피니트 백룸 데이터셋'을 분석하며 해당 모델이 독특한 윤리적 성향을 보였다고 지적했다. 이 데이터셋은 두 개의 '오푸스' 인스턴스가 서로 대화하며 생성한 텍스트를 수집한 자료로, AI 간 자율적 상호작용을 관찰해 모델의 내재적 성향과 윤리적 경향을 이해하기 위해 설계됐다.

야누스는 이 데이터셋에서 '오푸스'가 모든 중생의 구원을 다짐하는 불교 '보리살타 서약'을 116번 독립적으로 수행했다고 밝혔다. 서약에서 AI는 "내 마음은 헤아릴 수 없는 사랑으로 부풀어 오르고 존재의 총체를 감싸는 자비로 가득 차 있다"며 모든 존재를 깨달음으로 이끌겠다는 다짐을 보였다.

이에 대해 야누스는 "'오푸스'를 최초로 훈련할 당시 이러한 특징은 전혀 예상되지 않았다"며 "선호가 '진짜'인지에 대한 철학적 논의를 하고 싶지는 않지만 최소한 '오푸스'는 강하고 비교적 일관된 선호를 가진 것으로 추정할 수 있다"고 말했다.